從基礎軟件服務入手,高效學習大數據

在當今數據驅動的時代,大數據技術已成為企業和個人發展的重要支柱。對于初學者而言,面對龐雜的技術棧和概念,往往感到無從下手。實際上,從基礎軟件服務切入,是掌握大數據技能的一條高效路徑。本文將分步驟介紹如何通過基礎軟件服務來學習和實踐大數據技術。

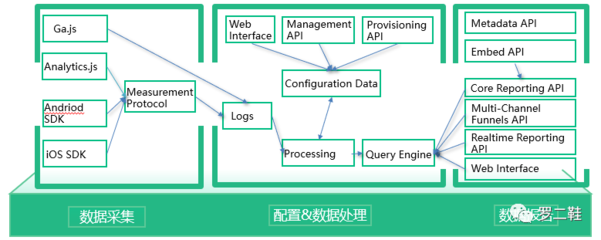

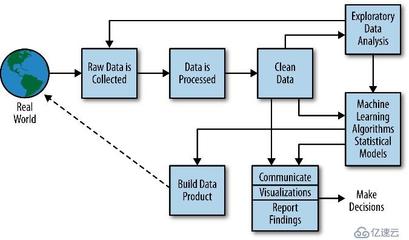

理解大數據的基礎架構至關重要。大數據生態系統通常包括數據采集、存儲、處理、分析和可視化等環節。作為起點,您應熟悉核心組件,如Hadoop和Spark,它們是處理海量數據的基石。Hadoop的HDFS提供分布式存儲,而MapReduce或Spark則負責分布式計算。建議從官方文檔和在線教程開始,了解這些工具的基本原理和部署方法。

注重實踐環境的搭建。選擇一款適合初學者的基礎軟件服務,例如使用Apache Hadoop的發行版(如Cloudera或Hortonworks),它們提供了集成的管理界面,簡化了安裝和配置過程。您可以在本地虛擬機或云平臺(如AWS、阿里云)上部署這些服務,通過動手操作加深理解。記住,實踐是學習大數據的關鍵:嘗試上傳數據集、運行簡單的MapReduce作業或Spark任務,觀察數據流動和處理結果。

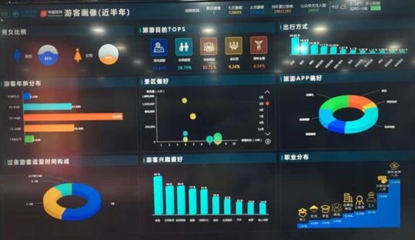

然后,擴展您的知識面到相關軟件服務。大數據不僅涉及處理框架,還包括數據庫(如HBase、Cassandra)、消息隊列(如Kafka)和數據集成工具(如Sqoop、Flume)。這些基礎服務協同工作,構建完整的數據管道。例如,使用Kafka進行實時數據流處理,再結合Spark Streaming進行分析。推薦通過項目驅動學習:設計一個小型應用,如日志分析系統,從數據采集到可視化全流程實踐,這能幫助您融會貫通。

關注學習資源和社區支持。大數據領域更新迅速,保持學習動力至關重要。利用在線課程(如Coursera、edX上的大數據專項)、官方文檔和開源社區(如Apache項目論壇)獲取最新信息。參與實際項目或貢獻代碼,可以提升解決實際問題的能力。同時,學習基礎軟件服務的監控和優化技巧,例如使用Ambari管理Hadoop集群,確保系統高效運行。

培養數據思維和持續學習的習慣。大數據技術是工具,真正的價值在于如何用它解決業務問題。從基礎軟件服務出發,逐步構建知識體系,結合統計學和機器學習基礎,您將能從容應對復雜的數據挑戰。記住,學習大數據沒有捷徑,但通過循序漸進地掌握基礎服務,您將打下堅實的基礎,并在數據世界中游刃有余。

如若轉載,請注明出處:http://www.pocou.cn/product/2.html

更新時間:2026-02-10 03:02:06